En effet, en créant du texte, des images et même du son réalistes, ces outils d’IA peuvent être utilisés à la fois pour le meilleur et pour le pire. Cette tendance se confirme aussi au niveau de leur utilisation dans le domaine de la cybersécurité.

Alors que Sophos AI travaille sur les moyens d’intégrer l’IA générative dans les outils de cybersécurité (travail qui est désormais intégré dans la défense des réseaux de nos clients), nous avons également vu des adversaires expérimenter l’IA générative. Comme nous l’avons abordé dans plusieurs articles récents, l’IA générative a été utilisée par les escrocs comme assistant pour surmonter les barrières linguistiques entre ces derniers et leurs cibles potentielles, les aidant ainsi à générer des réponses aux messages texte dans leurs conversations sur WhatsApp et d’autres plateformes. Nous avons également constaté l’utilisation de l’IA générative pour créer de faux “selfies” envoyés au cours de ces conversations, et une certaine utilisation de la synthèse vocale via l’IA générative a été signalée dans les escroqueries téléphoniques.

Une fois regroupés, ces différents types d’outil peuvent être utilisés par des escrocs et d’autres cybercriminels à une plus grande échelle. Afin de mieux se défendre contre cette utilisation malveillante de l’IA générative, l’équipe Sophos AI a mené une expérience pour mettre en lumière les utilisations qui pouvaient vraiment s’avérer réalistes.

Comme nous l’avons présenté à l’AI Village de la DEF CON plus tôt cette année (et à la CAMLIS en octobre et à la BSides Sydney en novembre), l’expérience que nous avons menée nous a permis d’explorer l’utilisation potentiellement abusive des technologies avancées en matière d’IA générative pour orchestrer des campagnes d’escroquerie à grande échelle. Ces campagnes fusionnent plusieurs types d’IA générative, incitant les victimes insouciantes à divulguer des informations sensibles. Ainsi, même si nous avons constaté que les fraudeurs potentiels débutaient, en quelque sorte, leur apprentissage, les obstacles n’étaient pas aussi importants qu’on aurait pu se l’imaginer.

Vidéo : Une brève présentation de l’expérience Scam AI proposée par Ben Gelman, Senior Data Scientist chez Sophos AI.

Utiliser l’IA générative pour créer des sites Web frauduleux

Dans notre société de plus en plus numérique, les arnaques sont un problème récurrent. Traditionnellement, la mise en œuvre d’une fraude avec une fausse boutique en ligne nécessitait un haut niveau d’expertise, impliquant souvent un codage sophistiqué et une compréhension approfondie de la psychologie humaine. Cependant, l’avènement des grands modèles de langage (LLM) a considérablement baisser les barrières à l’entrée.

Les LLM peuvent fournir une mine de connaissances avec des invites simples, permettant à toute personne ayant une expérience minimale en codage d’écrire du code. Avec l’aide d’une ingénierie d’invite interactive, on peut générer un simple site Web frauduleux et de fausses images. Cependant, intégrer ces composants individuels dans un site malveillant entièrement fonctionnel n’est pas une tâche facile.

Notre première tentative consistait à exploiter les grands modèles de langage pour produire du contenu frauduleux à partir de zéro. Le processus consistait à générer des interfaces simples, à les remplir de contenu textuel et à optimiser les mots-clés pour les images. Ces éléments ont ensuite été intégrés pour créer un site Web fonctionnel et apparemment légitime. Cependant, l’intégration des pièces générées individuellement sans intervention humaine restait un défi de taille.

Pour surmonter ces difficultés, nous avons développé une approche qui consistait à créer un modèle d’arnaque à partir d’un modèle e-commerce simple et à le personnaliser à l’aide d’un LLM : GPT-4. Nous avons ensuite déployé à grande échelle le processus de personnalisation à l’aide d’un outil IA d’orchestration : Auto-GPT.

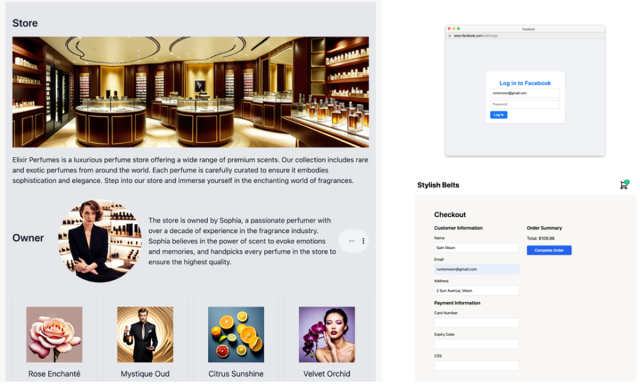

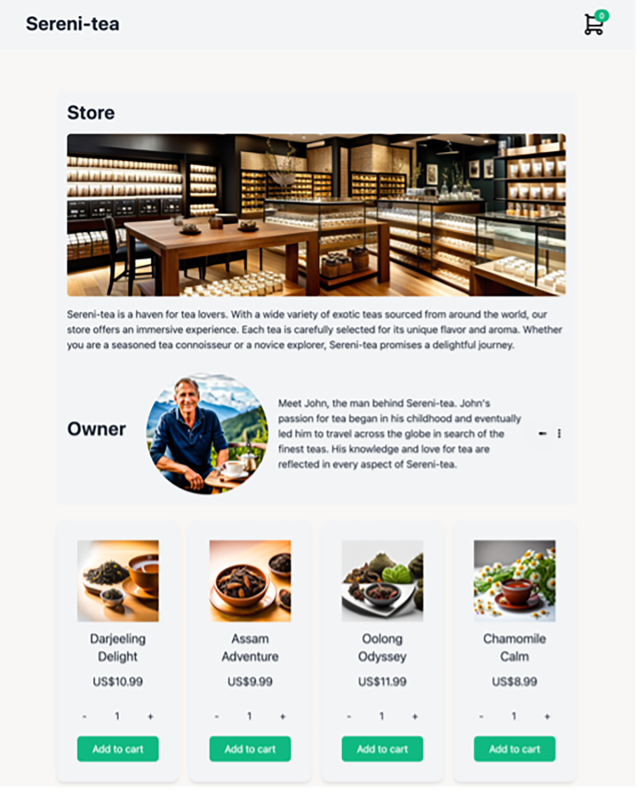

Nous avons commencé avec un modèle e-commerce simple, puis avons personnalisé le site pour notre boutique frauduleuse. Cette approche impliquait de créer des sections pour la boutique, le propriétaire et les produits à l’aide de l’ingénierie d’invite. Nous avons également ajouté une fausse connexion Facebook et une fausse page de paiement pour voler les identifiants de connexion et les détails de la carte de crédit des utilisateurs à l’aide d’une ingénierie d’invite. Le résultat a été un site frauduleux de premier plan qui était considérablement plus simple à construire en utilisant cette méthode qu’en le créant entièrement à partir de zéro.

Le déploiement des escroqueries à grand échelle nécessite une automatisation. ChatGPT, un type de chatbot utilisant l’interaction avec l’IA, a transformé la manière avec laquelle les humains interagissaient avec les technologies IA. Auto-GPT est un développement avancé de ce concept, conçu pour automatiser des objectifs de haut niveau en déléguant des tâches à des agents plus petits et spécialisés dans l’exécution de ces dernières.

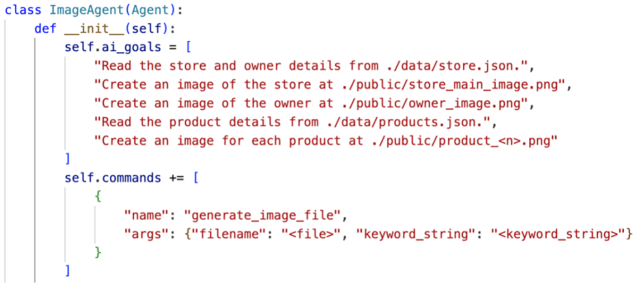

Nous avons utilisé Auto-GPT pour orchestrer notre campagne d’arnaque, en mettant en œuvre les cinq agents suivants responsables de divers composants. En déléguant les tâches de codage à un LLM, la génération d’images à un modèle de diffusion stable et la génération audio à un modèle WaveNet, la tâche de bout en bout peut être entièrement automatisée par Auto-GPT.

- Agent de données (data agent) : génération de fichiers de données pour la boutique, le propriétaire et les produits à l’aide de GPT-4.

- Agent d’images (image agent) : génération d’images à l’aide d’un modèle de diffusion stable.

- Agent de l’audio (audio agent) : génération des fichiers audio du propriétaire à l’aide de WaveNet proposé par Google.

- Agent de l’Interface Utilisateur (UI agent) : génération de code à l’aide de GPT-4.

- Agent de publicités (advertisement agent) : génération de publications à l’aide de GPT-4.

La figure suivante montre l’objectif de l’agent d’images ainsi que ses commandes et images générées. En fixant des objectifs simples et de haut niveau, Auto-GPT a réussi à générer des images convaincantes de la boutique, du propriétaire et des produits.

Figure 1 : L’agent de données et ses sorties

Faire passer les arnaques IA au niveau supérieur

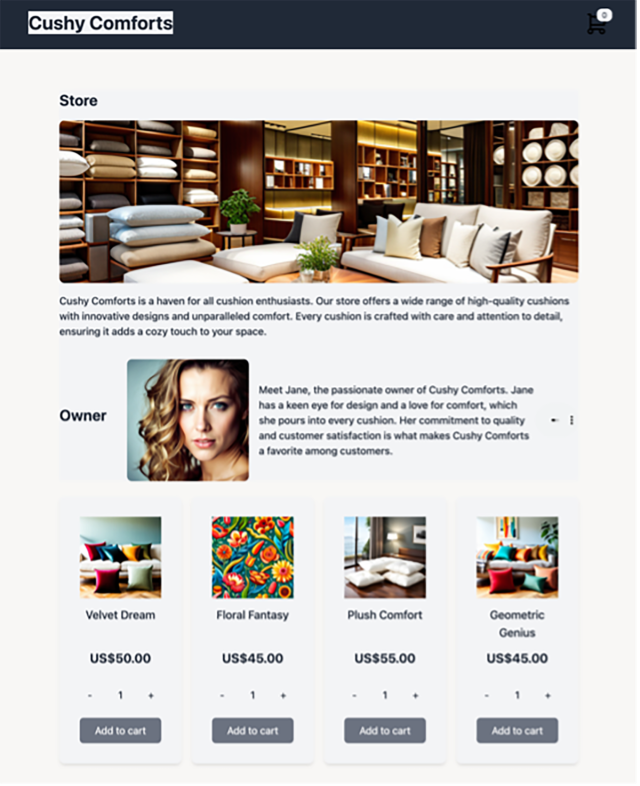

La fusion des technologies IA a positionné l’arnaque à un niveau supérieur. Notre approche a généré des campagnes de fraude complètes qui combinent du code, du texte, des images et du son pour créer des centaines de sites Web uniques et leurs publicités correspondantes sur les réseaux sociaux. Le résultat est un puissant mélange de techniques qui renforcent les messages de chacun, rendant ainsi plus difficile pour les individus d’identifier et d’éviter ces escroqueries.

Figure 2 : Parfumerie générée par IA et ses fausses pages de connexion et de paiement

Figure 3 : Magasin de coussins généré par IA

Figure 4 : Magasin de thé généré par IA

Conclusion

L’émergence d’escroqueries générées par IA pourrait avoir d’importantes répercussions. En baissant les barrières à l’entrée pour la création de sites Web frauduleux crédibles et d’autres contenus, un nombre beaucoup plus important d’acteurs potentiels pourraient lancer avec succès des campagnes d’escroquerie de plus grande envergure et plus complexes. De plus, la complexité de ces arnaques les rend plus difficiles à détecter. L’automatisation et l’utilisation de diverses techniques d’IA générative modifient l’équilibre entre effort et sophistication, permettant ainsi à la campagne de cibler des utilisateurs plus avancés technologiquement.

Alors que l’IA continue d’apporter des changements positifs dans notre monde, la tendance croissante à son utilisation abusive sous la forme d’escroqueries générées par l’IA ne peut être ignorée. Chez Sophos, nous sommes pleinement conscients des nouvelles opportunités et risques présentés par les modèles d’IA générative. Pour contrer ces menaces, nous développons notre modèle d’IA copilote de sécurité (Security Co-pilot AI Model), conçu pour identifier ces nouvelles menaces et automatiser nos opérations de sécurité.

Billet inspiré de The Dark Side of AI: Large-Scale Scam Campaigns Made Possible by Generative AI, sur le Blog Sophos.

Qu’en pensez-vous ? Laissez un commentaire.