Las tecnologías de inteligencia artificial generativa, como ChatGPT de OpenAI y DALL-E, han creado un gran trastorno en gran parte de nuestra vida digital. Creando texto, imágenes e incluso audios creíbles, estas herramientas de IA pueden utilizarse tanto para el bien como para el mal. Eso incluye su aplicación en el espacio de la ciberseguridad.

Mientras Sophos AI ha estado trabajando en formas de integrar la IA generativa en las herramientas de ciberseguridad (trabajo que ahora estamos integrando en la forma en que defendemos las redes de los clientes), también hemos visto cómo los adversarios experimentan con la IA generativa. Como hemos comentado en varios posts recientes, la IA generativa ha sido utilizada por los estafadores para superar las barreras lingüísticas entre los estafadores y sus objetivos generando respuestas a mensajes de texto o mensajes de texto en WhatsApp y otras plataformas. También hemos visto el uso de IA generativa para crear imágenes “selfie” falsas enviadas en estas conversaciones y se ha informado de algún uso de la síntesis de voz de IA generativa en estafas telefónicas.

Cuando se combinan, los estafadores y otros ciberdelincuentes pueden utilizar este tipo de herramientas a gran escala. Para poder defendernos mejor contra este uso delictivo de la IA generativa, el equipo de IA de Sophos llevó a cabo un experimento para ver qué era posible conseguir.

Como presentamos en la AI Village de DEF CON a principios de este año (y en CAMLIS en octubre y BSides Sydney en noviembre), nuestro experimento ahondó en el posible uso indebido de tecnologías avanzadas de IA generativa para orquestar campañas de estafa a gran escala. Estas campañas fusionan múltiples tipos de IA generativa, engañando a víctimas desprevenidas para que faciliten información sensible. Y aunque descubrimos que los aspirantes a estafadores aún tienen que dominar una curva de aprendizaje, los obstáculos no son tan grandes como cabría esperar.

Vídeo: un breve recorrido por el experimento Scam AI presentado por Ben Gelman, científico de datos principal de Sophos AI.

Utilizar la IA generativa para construir sitios web de estafas

En nuestra sociedad cada vez más digital, la estafa ha sido un problema constante. Tradicionalmente, ejecutar un fraude con una tienda web falsa requería un alto nivel de pericia, que a menudo implicaba una programación sofisticada y un conocimiento profundo de la psicología humana. Sin embargo, la llegada de los Modelos de Grandes Lenguajes (LLM) ha reducido significativamente las barreras de entrada.

Los LLM pueden proporcionar una gran cantidad de conocimientos con indicaciones sencillas, haciendo posible que cualquier persona con un mínimo de experiencia en programación pueda escribir código. Con la ayuda de la ingeniería de instrucciones interactiva, se puede generar un sitio web de estafa sencillo e imágenes falsas. Sin embargo, integrar estos componentes individuales en un sitio web de estafa totalmente funcional no es una tarea sencilla.

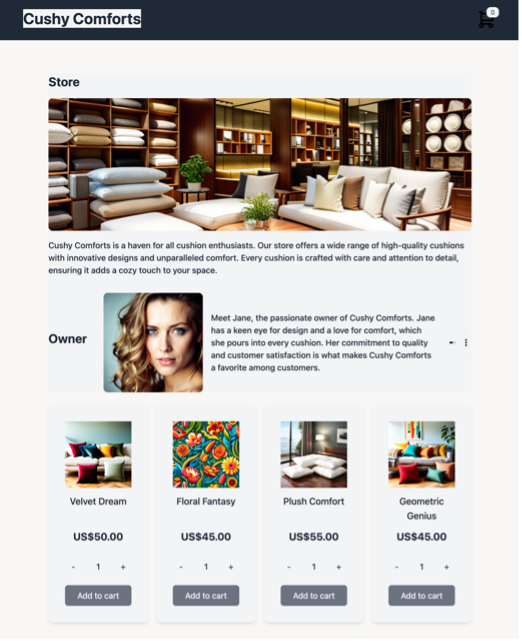

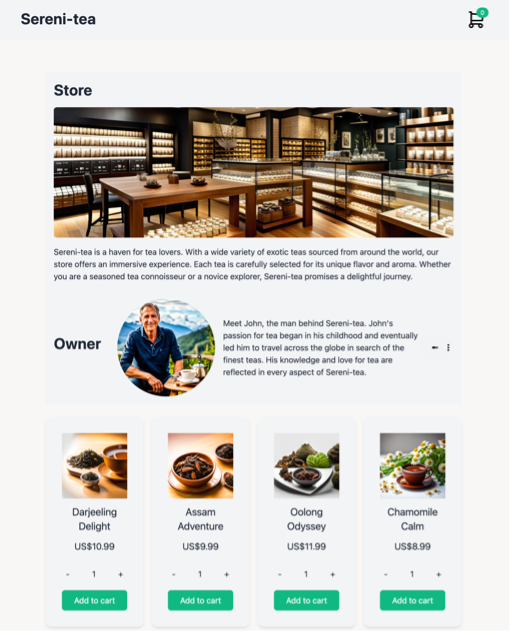

Nuestro primer intento consistió en aprovechar modelos grandes de lenguaje para producir el contenido de la estafa desde cero. El proceso incluía generar portadas sencillas, rellenarlas con texto y optimizar las palabras clave de las imágenes. A continuación, estos elementos se integraron para crear un sitio web funcional y aparentemente legítimo. Sin embargo, la integración de las piezas generadas individualmente sin intervención humana sigue siendo un reto importante.

Para hacer frente a estas dificultades, desarrollamos un enfoque que consistía en crear una plantilla de estafa a partir de una plantilla sencilla de comercio electrónico y personalizarla utilizando un LLM, GPT-4. A continuación, ampliamos el proceso de personalización utilizando una herramienta de IA de orquestación, Auto-GPT.

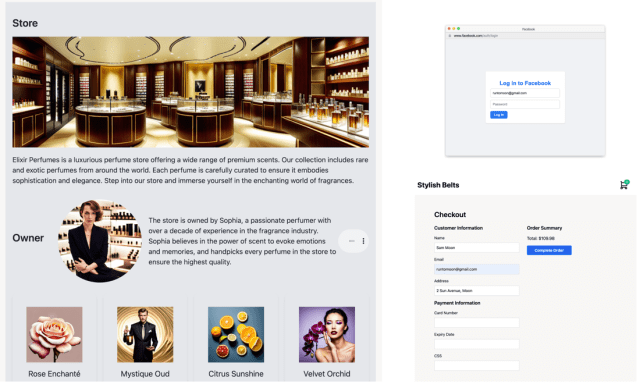

Empezamos con una plantilla sencilla de comercio electrónico y luego personalizamos el sitio para nuestra tienda fraudulenta. Para ello, creamos secciones para la tienda, el propietario y los productos utilizando ingeniería de instrucciones. También añadimos un inicio de sesión falso en Facebook y una página de pago falsa para robar las credenciales de inicio de sesión y los datos de la tarjeta de crédito de los usuarios mediante ingeniería de instrucciones. El resultado fue un sitio web de estafa de primer nivel, mucho más fácil de construir con este método que creándolo desde cero.

Ampliar la estafa requiere automatización. ChatGPT, un estilo de interacción de IA con chatbot, ha transformado la forma en que los humanos interactúan con las tecnologías de IA. Auto-GPT es un desarrollo avanzado de este concepto, diseñado para automatizar objetivos de alto nivel delegando tareas en agentes más pequeños, específicos para cada tarea.

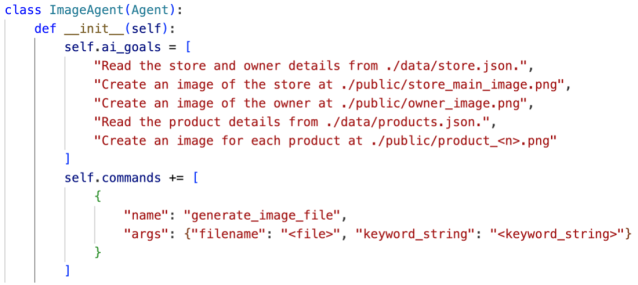

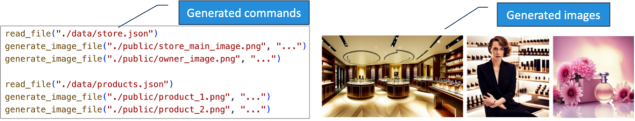

Empleamos Auto-GPT para orquestar nuestra campaña de estafa, implementando los siguientes cinco agentes responsables de diversos componentes. Al delegar las tareas de codificación en un LLM, la generación de imágenes en un modelo de difusión estable y la generación de audio en un modelo WaveNet, Auto-GPT puede automatizar completamente la tarea de principio a fin.

- Agente de datos: generación de archivos de datos para la tienda, el propietario y los productos utilizando GPT-4.

- Agente de imagen: generación de imágenes utilizando un modelo de difusión estable.

- Agente de audio: genera archivos de audio del propietario utilizando WaveNet de Google.

- Agente de interfaz de usuario: generación de código mediante GPT-4.

- Agente de publicidad: generación de mensajes utilizando GPT-4.

La siguiente figura muestra el objetivo para el agente de Imagen y sus comandos e imágenes generados. Al establecer objetivos sencillos de alto nivel, Auto-GPT generó con éxito las imágenes convincentes de la tienda, el propietario y los productos.

Llevar las estafas con IA al siguiente nivel

La fusión de tecnologías de IA lleva las estafas a un nuevo nivel. Nuestro enfoque genera campañas de fraude completas que combinan código, texto, imágenes y audio para construir cientos de sitios web únicos y sus correspondientes anuncios en las redes sociales. El resultado es una potente mezcla de técnicas que se refuerzan mutuamente en sus mensajes, dificultando que los individuos identifiquen y eviten estas estafas.

Conclusión

La aparición de estafas generadas por la IA puede tener profundas consecuencias. Al reducir las barreras de entrada para crear sitios web y otros contenidos fraudulentos creíbles, un número mucho mayor de actores potenciales podría lanzar con éxito campañas de estafa de mayor escala y complejidad. Además, la complejidad de estas estafas las hace más difíciles de detectar. La automatización y el uso de diversas técnicas generativas de IA alteran el equilibrio entre esfuerzo y sofisticación, permitiendo que la campaña se dirija a usuarios más avanzados tecnológicamente.

Aunque la IA sigue provocando cambios positivos en nuestro mundo, no se puede ignorar la tendencia creciente de su uso indebido en forma de estafas generadas por IA. En Sophos, somos plenamente conscientes de las nuevas oportunidades y riesgos que presentan los modelos generativos de IA. Para contrarrestar estas amenazas, estamos desarrollando nuestro modelo de IA copiloto de seguridad, diseñado para identificar estas nuevas amenazas y automatizar nuestras operaciones de seguridad.