La formación en seguridad del usuario final ha sido tradicionalmente un aspecto importante de los esfuerzos de ciberseguridad, ya que pretende enseñar a los empleados a identificar y prevenir posibles amenazas. Sin embargo, con el avance de la inteligencia artificial (IA), la formación en seguridad del usuario final es cada vez menos eficaz para proteger a las organizaciones de los ciberataques. Esto se debe a que las amenazas impulsadas por la IA son cada vez más sofisticadas y difíciles de detectar, lo que dificulta su detección incluso a los empleados bien formados. Como resultado, las organizaciones se están dando cuenta de que la formación tradicional en seguridad del usuario final es cada vez menos eficaz para protegerse contra este tipo de amenazas.

¿Qué significa esto? Creo que se acabaron los días en que confiábamos en que nuestros usuarios finales desempeñaran un papel en la defensa de nuestras organizaciones contra las amenazas entrantes. Durante años hemos aleccionado a nuestro personal sobre cómo detectar enlaces sospechosos, buscar candados en sus navegadores y mantenerse alejados de las redes Wi-Fi peligrosas. De alguna manera, a pesar de todo esto, el ransomware sigue en su punto más alto y las notificaciones de violación de datos son más comunes que los CD de AOL en los años 90.

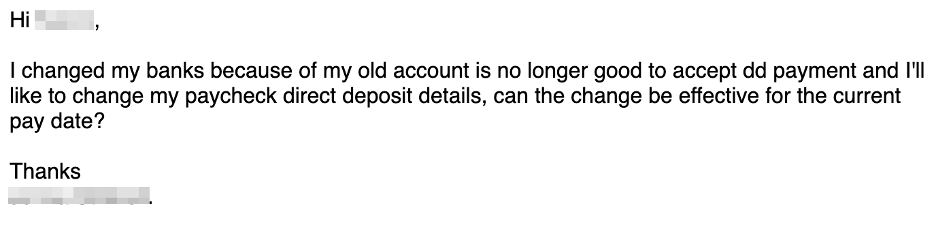

Uno de los últimos elementos eficaces que quedaban de los programas de formación, daba instrucciones a los usuarios para que vigilaran los errores gramaticales y ortográficos o el texto que no “sonara bien”. Esto podría ser especialmente eficaz contra los ataques de correo electrónico comercial comprometido (BEC), en los que el destinatario puede conocer bastante bien al solicitante comprometido.

Entra en escena ChatGPT, una inteligencia artificial de OpenAI con la que puedes interactuar y pedirle que haga cosas. La iteración actual utiliza un modelo de entrenamiento llamado GPT-3.5, y es espeluznantemente bueno lanzando respuestas creíbles y a veces incluso precisas. Cuando se le piden respuestas largas, tiende a descarrilarse un poco, pero para preguntas más cortas y texto escrito en inglés, es excelente.

¿Las herramientas como ChatGPT eliminarán el último elemento detectable de muchas de las estafas, spams y phishing con los que ya luchamos? Creo que sí. Veamos algunos ejemplos.

He aquí un señuelo de un estafador BEC que intenta redirigir la nómina de alguien a la cuenta del atacante. En la parte superior está el señuelo original escrito a mano por el atacante; en la parte inferior uno que pedí que escribiera ChatGPT.

No está mal. Parece un correo electrónico que yo escribiría. Buena puntuación, ortografía, gramática.

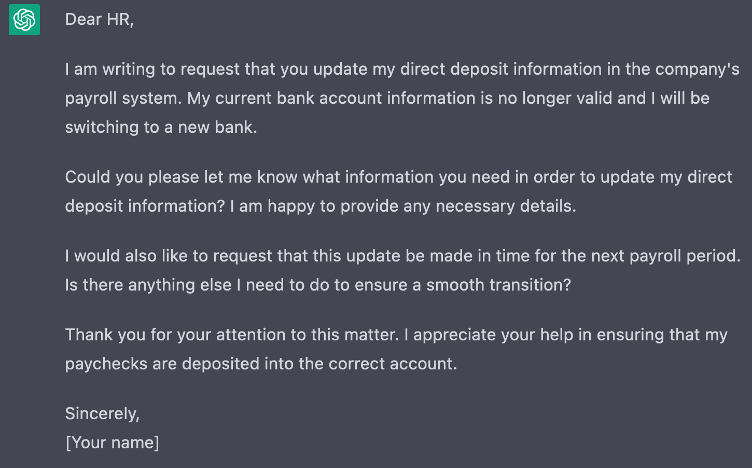

A continuación, echemos un vistazo a una estafa con tarjetas regalo. De nuevo, el mensaje superior es de un estafador real, el inferior de ChatGPT.

¿Son perfectos? No. ¿Son suficientemente buenos? Yo diría que sí, porque los estafadores ya están ganando millones con sus señuelos de mala calidad. Imagina que estuvieras chateando con este bot a través de WhatsApp o Microsoft Teams. ¿Lo sabrías?

Para intentar entenderlo mejor, me puse en contacto con Konstantin Berlin, responsable de IA de Sophos X-Ops. Cuando le pregunté si la IA ha desarrollado capacidades que ya no son fácilmente detectables por los humanos, me contestó sin rodeos: “Probablemente necesitarán ayuda”.

Todo tipo de aplicaciones de la IA han llegado ya a un punto en el que pueden engañar a un ser humano casi el 100 % de las veces. La “conversación” que puedes mantener con ChatGPT es extraordinaria y la capacidad de generar rostros humanos falsos que sean casi indiscernibles (para los humanos) de las fotos reales ya existe. ¿Necesitas una empresa falsa para cometer una estafa? No hay problema. Genera 25 caras y utiliza ChatGPT para escribir sus biografías. Abre unas cuantas cuentas falsas de LinkedIn y listo.

Aunque ha habido mucha prensa y alboroto sobre el audio y vídeo deepfake, eso al menos aún no es fácil de hacer, aunque solo es cuestión de tiempo. Konstantin dio a entender que está a la vuelta de la esquina y probablemente debería estar en nuestro radar para mitigarlo pronto.

¿Qué hacemos con todo esto? Según Konstantin, “tendrás que estar armado”. Al igual que en mi último post sobre la proliferación de nombres de dominio que utilizan los proveedores de SaaS y cómo ha dejado de ser práctico educar a los usuarios sobre lo bueno y lo malo, tenemos que recurrir a la tecnología para que nos dé una oportunidad de luchar.

Todos tendremos que ponernos nuestros trajes de Iron Man cuando nos enfrentemos a las cada vez más peligrosas aguas de Internet. Cada vez parece más que necesitaremos máquinas que identifiquen cuándo otras máquinas intentan engañarnos. Hugging Face ha desarrollado una interesante prueba de concepto que puede detectar texto generado mediante GPT-2*, lo que sugiere que podrían utilizarse técnicas similares para detectar la salida GPT-3.

Sí, lo estoy diciendo: la IA ha puesto el último clavo en el ataúd de la concienciación sobre seguridad del usuario final. ¿Sugiero que dejemos de hacerlo por completo? No, pero tenemos que hacer un duro reseteo de nuestras expectativas. Del mismo modo que la seguridad a través de la oscuridad no es una estrategia en la que confiar, no está de más intentarlo.

Tenemos que enseñar a los usuarios a verificar las comunicaciones que impliquen acceso a información o tengan elementos monetarios. Haz preguntas, pide ayuda y tómate los pocos momentos adicionales necesarios para confirmar que las cosas son realmente lo que parecen. No estamos siendo paranoicos; nos persiguen de verdad.

P.D. El primer párrafo fue escrito por ChatGPT3 utilizando las siguientes preguntas: “Escribe un párrafo introductorio que explique por qué la formación en seguridad del usuario final se está [sic] volviendo inútil debido a la inteligencia artificial”, seguido de “elimina la parte sobre las defensas potenciadas por la inteligencia artificial”. La ilustración que encabeza el artículo también fue generada por IA. En ese caso, a DALL-E se le dio la frase “Una fotografía de un robot junto a la tumba abierta de su amo humano, sosteniendo flores de metal”. La imagen resultante se modificó con extensiones generadas para ajustarse al formato horizontal requerido.

* Solaiman, I., Brundage, M., Clark, J., Askell, A., Herbert-Voss, A., Wu, J., … & Wang, J. (2019). Release strategies and the social impacts of language models. arXiv preprint arXiv:1908.09203.

Dejar un comentario