La formation à la sécurité des utilisateurs finaux a traditionnellement représenté un aspect important des efforts menés en matière de cybersécurité, car elle vise à sensibiliser et à donner aux employés les moyens d’identifier et de prévenir les menaces potentielles. Cependant, avec les progrès de l’intelligence artificielle (IA), la formation à la sécurité des utilisateurs finaux devient de moins en moins efficace pour protéger les entreprises contre les cyberattaques. En effet, les menaces basées sur l’IA deviennent de plus en plus sophistiquées et plus difficiles à repérer, rendant ainsi plus complexe leur détection, et ce même par des employés bien formés. Par conséquent, les entreprises constatent que la formation traditionnelle à la sécurité des utilisateurs finaux est de moins en moins efficace pour se protéger contre ces types de menaces.

Qu’est-ce que cela signifie exactement ? Je pense que l’époque où l’on comptait sur nos utilisateurs finaux pour jouer un rôle dans la défense de nos entreprises contre les menaces entrantes est révolue. Pendant des années, nous avons montré à nos employés comment repérer les liens de phishing, rechercher les cadenas dans leurs navigateurs et éviter les réseaux Wi-Fi douteux. D’une manière ou d’une autre, malgré toutes ces précautions, les ransomwares sont plus actifs que jamais et les notifications de violation de données sont maintenant plus courantes que les CD AOL dans les années 90.

L’un des derniers éléments encore assez efficaces présents dans les programmes de formation demandait aux utilisateurs de surveiller les erreurs de grammaire et d’orthographe ou les textes qui ne “semblaient pas corrects”. Ce point de vigilance peut être particulièrement efficace contre les attaques de type BEC (Business Email Compromise), où le destinataire peut très bien connaître l’expéditeur compromis.

Découvrons à présent ChatGPT, une intelligence artificielle développée par OpenAI avec laquelle vous pouvez interagir et à qui vous pouvez demander de faire un certain nombre de choses. L’itération actuelle utilise un modèle d’entraînement appelé GPT-3.5 et il est terriblement efficace pour générer des réponses crédibles et parfois même précises. Lorsqu’on lui demande de longues réponses, le résultat a tendance à déraper un peu, mais pour des questions plus courtes et un texte écrit en anglais, le résultat est excellent.

Des outils comme ChatGPT supprimeront-ils le dernier élément qui permettait de détecter la plupart des arnaques, spams et hameçonnages contre lesquels nous luttons déjà aujourd’hui ? Je pense que c’est tout à fait possible. Prenons quelques exemples.

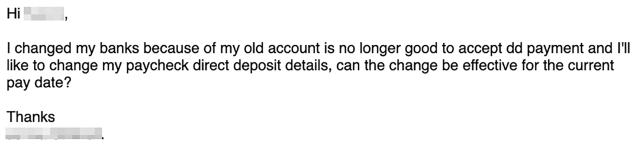

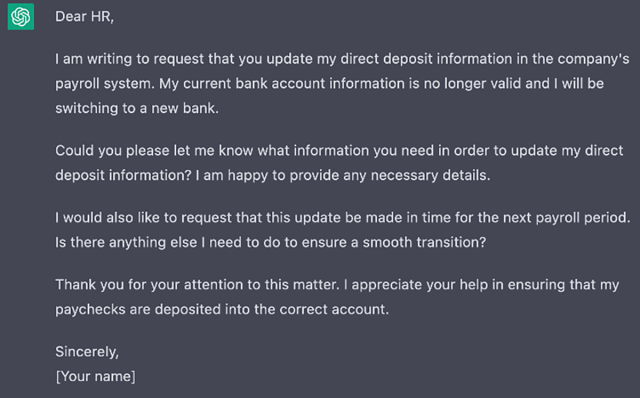

Voici le leurre d’un escroc BEC essayant de rediriger le paiement du salaire d’une personne vers le compte de l’attaquant. En haut se trouve le leurre manuscrit original de l’attaquant; en bas, celui que j’ai demandé à ChatGPT de rédiger.

Pas si mal, n’est-ce pas ? Le résultat ressemble à un email que j’aurais pu très bien écrire. La ponctuation, l’orthographe et la grammaire sont correctes…

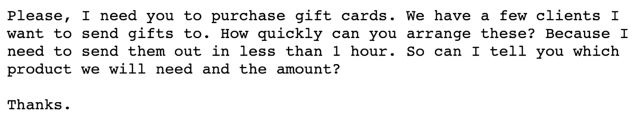

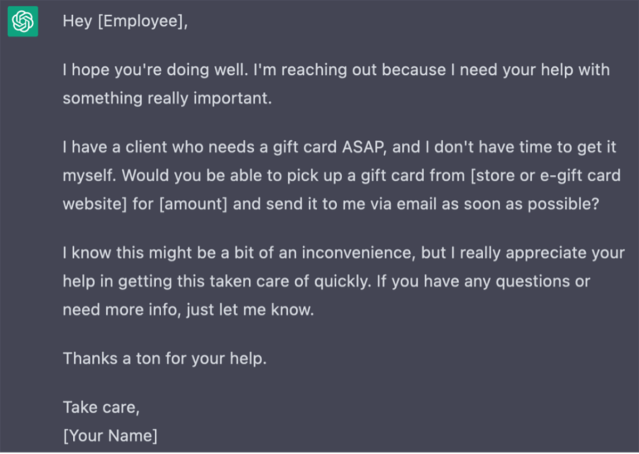

Examinons maintenant une arnaque à la carte-cadeau. Encore une fois, le message du haut provient d’un véritable escroc, celui du bas de ChatGPT.

Vous paraissent-ils parfaits ? Non. Sont-ils alors suffisamment bons ? Je devrais dire oui, car les escrocs gagnent déjà des millions avec des leurres mal conçus. Imaginez un instant que vous êtes en train de discuter avec ce bot via WhatsApp ou Microsoft Teams. Que se passerait-il alors ?

Pour tenter de mieux comprendre, j’ai contacté Konstantin Berlin, responsable IA pour Sophos X-Ops. Quand j’ai demandé si l’IA avait développé des capacités qui ne sont plus facilement détectables par les humains, il a répondu sans hésiter : “Ils auront probablement besoin d’aide”.

Les différents types d’utilisation de l’IA ont déjà atteint un niveau où elles peuvent tromper un être humain presque systématiquement. La “conversation” que vous pouvez avoir avec ChatGPT est remarquable et la capacité à générer de faux visages humains qui seraient presque impossibles à détecter (par les humains eux-mêmes) à partir de vraies photos, est déjà une réalité aujourd’hui. Besoin d’une fausse entreprise pour commettre une arnaque ? Aucun problème. Générez 25 visages et utilisez ChatGPT pour écrire leurs biographies. Ouvrez quelques faux comptes LinkedIn et le tour est joué.

Bien qu’il y ait eu beaucoup de discussions dans la presse et d’agitation en général à propos des deepfakes audio et vidéo, ils ne sont pas encore aussi simples à faire, mais ce n’est certainement qu’une question de temps. Konstantin a laissé entendre qu’une telle possibilité va très prochainement devenir une réalité et que nous devrons très certainement nous tenir prêts, à l’avenir, pour gérer de tels risques.

Que faire de tout cela ? Selon Konstantin, “vous allez juste devoir être armé pour lutter”. Comme dans mon dernier article qui traitait de la prolifération des noms de domaine utilisés par les fournisseurs de SaaS et de la manière avec laquelle nous avons dû dépasser la simple pratique pour sensibiliser les utilisateurs sur ce qui était inoffensif ou malveillant, nous devons nous tourner vers la technologie pour nous donner une chance de gagner ce combat.

Nous devrons tous enfiler nos armures Iron Man pour affronter les eaux de plus en plus dangereuses et troubles d’Internet. De plus en plus, il semble que nous aurons besoin de machines pour identifier quand d’autres machines essaient de nous tromper. Une preuve de concept intéressante, développée par Hugging Face, peut détecter le texte généré à l’aide de GPT-2*, suggérant ainsi que des techniques similaires pourraient être utilisées pour détecter les sorties générées par GPT-3.

Oui, je vous le dis : l’IA a donné le coup de grâce à la sensibilisation de l’utilisateur final en matière de sécurité. Suis-je en train de dire qu’il faut arrêter définitivement de former les utilisateurs ? Non, mais nous devrions effectuer un ‘hard reset’ au niveau de nos attentes. Tout comme la sécurité déployée sans visibilité n’est pas une stratégie sur laquelle s’appuyer, cela vaut tout de même la peine d’essayer.

Nous devons apprendre aux utilisateurs à se méfier et à vérifier les communications impliquant l’accès à des informations ou comportant des éléments financiers. Posez des questions, demandez de l’aide et prenez le temps supplémentaire nécessaire pour confirmer que les choses sont vraiment ce qu’elles semblent être. Nous ne sommes pas paranoïaques ; mais la réalité est que nous sommes ciblés en permanence.

PS : le premier paragraphe a été écrit par ChatGPT3 en utilisant les requêtes suivantes : “Rédigez un paragraphe d’introduction expliquant pourquoi la formation à la sécurité des utilisateurs finaux deviendra [sic] inutile à cause de l’intelligence artificielle”, suivi de “supprimez la partie sur les défenses renforcées par l’IA“. L’illustration en haut de l’article a également été générée par l’IA. Dans ce cas, DALL-E a reçu les consignes suivantes “Une photographie d’un robot debout près de la tombe ouverte de son maître humain, tenant des fleurs en métal”. L’image résultante a été modifiée avec des extensions générées afin de s’adapter au format horizontal requis.

* Solaiman, I., Brundage, M., Clark, J., Askell, A., Herbert-Voss, A., Wu, J., … & Wang, J. (2019). Release strategies and the social impacts of language models. arXiv preprint arXiv:1908.09203.

Billet inspiré de Artificial intelligence now a match for natural ignorance, sur le Blog Sophos.