2020 está siendo un año clave para el aprendizaje automático, con la llegada del aprendizaje automático comercial, donde los modelos y algoritmos de aprendizaje profundo están fácilmente disponibles para los usuarios de Internet. Las GPU son más baratas y están más disponibles que nunca, y los nuevos métodos de capacitación, como el aprendizaje por transferencia, han hecho posible disponer de modelos de aprendizaje profundo potentes utilizando conjuntos de datos más pequeños.

Pero esto también tiene sus inconvenientes. A comienzos de año hablábamos de Clearview, una empresa que había acumulado una enorme base de datos de más de tres mil millones de imágenes obtenidas de webs de empleo, de noticias, educativas y redes sociales como Facebook, YouTube, Twitter, Instagram y Venmo y que había estado vendiendo silenciosamente el acceso a huellas faciales y software de reconocimiento facial a las agencias policiales en todo Estados Unidos, alegando que puede identificar a una persona en una sola foto, revelando su nombre real y mucho más.

De hecho el reconocimiento facial es un tema que actualmente está en los juzgados de muchos países debido a su mal uso tanto por las fuerzas del orden como por parte de empresas, por ejemplo Clearview.

Lo que está claro es que pese a que cada vez más estamos preocupados por nuestra privacidad, seguimos inundando las redes sociales con fotos en las que se nos reconoce perfectamente, por lo que herramientas como Fawkes son muy bienvenidas.

Fawkes, desarrollado por el SAND Lab de la Universidad de Chicago, es un software que limita cómo se pueden usar las imágenes con fines de rastreo. Fawkes realiza pequeños cambios a nivel de píxel en las imágenes que son invisibles para el ojo humano, en un proceso que llamamos “encubrimiento” de imágenes. Estas fotos “encubiertas” se pueden utilizar como lo harías normalmente, compartiéndolas en las redes sociales, enviándolas a amigos, imprimiéndolas o mostrándolas en dispositivos digitales, de la misma manera que lo harías con cualquier otra foto. La diferencia es que si alguien intenta usar estas fotos para construir un modelo de reconocimiento facial, las imágenes “encubiertas” le enseñarán al modelo una versión muy distorsionada de lo que te hace parecerte a ti. El efecto de capa no es fácilmente detectable por humanos o máquinas, sin embargo, cuando alguien intenta identificarte presentando una imagen tuya inalterada y “sin encubrir” (por ejemplo, una foto tomada en público) basándose en las “encubiertas”, no te reconocerá.

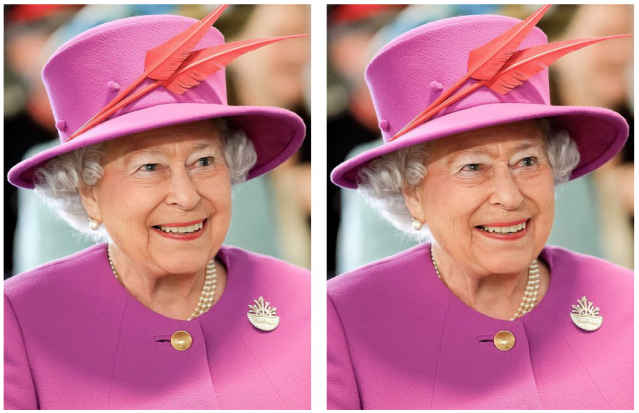

Como puedes ver en el siguiente ejemplo, es prácticamente imposible para el ojo humano identificar cuando una imagen está “encubierta”:

Según sus creadores, esta técnica de “encubrimiento” ha logrado engañar a los sistemas de reconocimiento facial comercializados por Microsoft, Amazon y Google el 100% de las veces, por lo que si estás preocupado por tu privacidad en las redes sociales y como empresas de reconocimiento facial pueden utilizar tus imágenes, quizás Fawkes es una solución muy interesante para ti.

Por si no lo sabías el nombre Fawkes es un homenaje a Guy Fawkes, cuya imagen fue inmortalizada por la famosa mascara de V de Vendeta y que utiliza el grupo Anonymous.