Les employeurs s’offusquent régulièrement de ce qu’ils découvrent au sujet de potentiels futurs embauchés sur les réseaux sociaux : à savoir du contenu provocateur, des publications sur la consommation d’alcool ou de drogues, des publications racistes/ sexistes/intolérantes sur le plan religieux, du dénigrement d’autrui, des mensonges au sujet des qualifications, des aptitudes médiocres en matière de communication, un comportement criminel, ou le partage des données confidentielles d’un ancien employeur, pour ne citer que quelques exemples.

Nous devrions tous considérer comme allant de soi que nos publications sur les réseaux sociaux puissent faire l’objet, de nos jours, d’un examen approfondi. Cela vaut également pour ceux d’entre nous dont le cortex préfrontal se résume encore à un amas de gélatine en formation, à savoir les enfants et les adolescents.

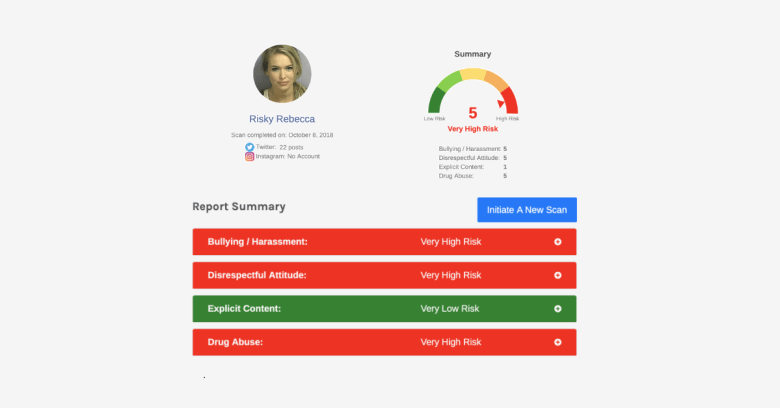

En fait, il existe une application utilisant l’Intelligence Artificielle (IA) qui permet de comprendre ce que les cerveaux émotionnels, impulsifs, à dominance amygdale des enfants publient en ligne : elle s’appelle Predictim et est financée par l’accélérateur Skydeck de Berkeley basé à l’Université de Californie. Predictim analyse les comptes Facebook, Instagram et Twitter pour fournir une “évaluation du risque” sur une échelle de 1 à 5, permettant de prédire si les baby-sitters ou les promeneurs de chiens pourraient avoir une mauvaise influence, voire même s’avérer dangereux.

Vous pouvez sympathiser avec sa clientèle : Predictim présente des cas réels de baby-sitters malveillants qui ont causé des blessures mortelles ou quasi fatales aux enfants dont ils avaient la charge. Selon la société, de simples vérifications des antécédents ou des références via le bouche à oreille ne détectent pas nécessairement les facteurs de risque mentionnés dans le rapport, notamment des preuves d’intimidation ou de harcèlement, de toxicomanie, de comportement irrespectueux ou discourtois ou de publication de contenu explicite.

L’entreprise affirme qu’après avoir dirigé l’outil vers les publications des réseaux sociaux concernant deux baby-sitters accusés d’avoir fait du mal à des enfants, celui-ci a renvoyé l’évaluation “très dangereuse”. Mais, si vous et moi pouvons sympathiser avec les parents, Facebook et Twitter, quant à eux, n’apprécient pas que Predictim s’adonne au scraping de données des utilisateurs pour parvenir à tirer de telles conclusions.

La BBC a signalé que Facebook avait révoqué au début du mois la plupart des accès de Predictim aux utilisateurs, pour violation de la politique de la plateforme en matière d’utilisation des données personnelles.

Après que Predictim ait déclaré qu’il était toujours en mesure d’effectuer du scraping de données publiques au niveau de Facebook pour alimenter ses algorithmes, Facebook a lancé une enquête afin de déterminer s’il devait bloquer complètement Predictim.

La BBC a cité le directeur général et co-fondateur de Predictim, Sal Parsa, qui a déclaré: “attendez, il s’agit de données publiques, non ? donc où est le problème ?” :

Tout le monde s’intéresse et observe les gens sur les réseaux sociaux. On recherche tous certaines personnes également sur Google. Nous avons simplement automatisé ce processus.

Facebook n’a pas été, à priori, du même avis. Selon un porte-parole de la plateforme sociale :

Le fait de faire du scraping de données d’utilisateurs de Facebook va à l’encontre de nos conditions de générales d’utilisation. Nous enquêterons sur Predictim concernant de potentielles violations de nos conditions, notamment pour voir si l’entreprise pratique activement, le scraping de données.

Twitter, après avoir découvert les activités de Predictim, a diligenté une enquête et a finalement révoqué récemment son accès aux API publiques de la plateforme. L’entreprise a déclaré à la BBC :

Nous interdisons strictement l’utilisation des données Twitter et des API à des fins de surveillance, y compris pour effectuer des vérifications d’antécédents. Lorsque nous avons pris connaissance des services proposés par Predictim, nous avons mené une enquête et avons décidé de révoquer leur accès aux API publiques de Twitter.

Predictim utilise des algorithmes de traitement du langage naturel et d’apprentissage automatique qui parcourent des années de publications sur les réseaux sociaux. Il génère ensuite un score d’évaluation des risques, accompagné du signalement de certaines publications et enfin d’une catégorisation de la personnalité de l’individu : toxicomanie, intimidation et harcèlement, contenu explicite et attitude irrespectueuse.

Predictim a été lancé le mois dernier, mais le Washington Post a publié un article suggérant que Predictim était réducteur, simpliste, en sortant de leurs contextes des messages sur les réseaux sociaux, à tendance ironiques et sarcastiques, mais plutôt classiques en période d’adolescence. De plus, il dépendait d’”algorithmes de type black-box” qui ne laissaient pas à des humains la possibilité de discerner certaines nuances. L’article souligne que :

Les systèmes reposent sur des algorithmes de type black-box qui donnent peu de détails sur la manière dont ils ont réduit la complexité de la vie intime d’une personne en un calcul de la vertu ou de la nuisance. Et même si la technologie de Predictim influence la pensée des parents, elle n’a toujours pas été prouvée, en grande partie inexpliquée et toujours vulnérable vis-à-vis de l’avis très subjectif concernant la façon dont un baby-sitter, digne de ce nom, devrait interagir, se comporter et communiquer.

Predictim‘s black-box algorithm analyzes babysitters‘ social media accounts, reducing them to a single fit score. Beyond disgusting. Downright evil.

Social media algorithms prod you to be the worst/fake you can be, hiring algorithms reject you for it. https://t.co/fi0NlZsTBV

— DHH (@dhh) 24 novembre 2018

Parsa a déclaré à la BBC que Predictim n’utilisait pas une “blackbox magique” :

Si l’IA désigne une personne comme malveillante, il existe une preuve justifiant que cette dernière a bien été considérée comme malveillante.

Mais la véritable logique derrière cette évaluation n’a pas été clarifiée : Drew Harwell, du Post, s’est entretenu avec une mère “énervée” qui a déclaré que, lorsque l’outil signalait un baby-sitter au comportement potentiellement harcelant, il ne pouvait pas dire si le logiciel avait repéré une vieille citation de film, les paroles d’une chanson ou tout autre phrase extraite, par opposition à de réels propos d’harcèlement”.

L’entreprise insiste sur le fait que Predictim n’est pas conçu comme un outil à utiliser pour prendre des décisions en matière d’embauche, et que l’évaluation fournie n’est qu’une simple assistance à la décision. Mais cela n’empêche pas l’entreprise d’utiliser des phrases comme celle-ci sur le tableau de bord du site :

Cette personne est réellement susceptible de se comporter de manière inappropriée (forte probabilité d’être un mauvais candidat à l’embauche).

Les experts en technologie avertissent que la plupart des algorithmes utilisés pour analyser le langage naturel et les images sont loin d’être infaillibles. Par exemple, Facebook a eu du mal à mettre en place des systèmes permettant de détecter automatiquement les discours de haine.

Le Post a parlé à l’avocat de l’Electronic Frontier Foundation, Jamie L. Williams, qui a déclaré que les algorithmes sont particulièrement mauvais pour analyser, en particulier, ce qui sort de la bouche des enfants :

Appliquer ce système sur des paroles d’adolescents : soyons sérieux, ce ne sont que des enfants ! Les enfants blaguent en permanence. Ils sont naturellement sarcastiques. Des propos qui pourraient ressembler à une “mauvaise attitude” vis-à-vis de l’algorithme pourraient, par ailleurs, apparaître aux yeux d’un tiers comme une déclaration politique ou une critique justifiée.

En fait, Malissa Nielsen, une baby-sitter âgée de 24 ans qui a accepté de donner à Predictim l’accès à ses comptes sur les réseaux sociaux, à la demande de deux familles distinctes, a confié au Post qu’elle avait été choquée lorsqu’on lui avait donné des notes injustifiées concernant le harcèlement et le manque de respect.

Nielsen a déclaré qu’elle n’avait rien à se reprocher. Elle a toujours fait attention à ses publications, n’est pas malveillante, va à l’église toutes les semaines et termine sa formation en éducation de la petite enfance. Elle dit qu’elle espère ouvrir une école maternelle.

Comment Predictim a-t-elle pu trouver du “harcèlement” et du “manque de respect” me concernant, se demandait-elle ?

J’aurais bien voulu mener ma propre enquête. Comment peuvent-ils penser cela de moi ? Un ordinateur n’a pas de sentiments. Il ne peut pas tirer de telles conclusions.

Malheureusement, un ordinateur pense que oui, et l’entreprise derrière lui est disposée à facturer 24,99$ (environ 22€) aux parents pour des prestations dont la fiabilité, selon certains experts, est loin d’être prouvée !

Le Post a cité Miranda Bogen, senior policy analyst chez Upturn, un groupe de réflexion basé à Washington qui étudie comment les algorithmes sont utilisés dans la prise de décision automatisée et la justice pénale :

Il n’existe pas encore de moyens de mesurer si ces outils sont vraiment efficaces pour prédire ce qu’ils disent être capables de faire. L’attractivité de ces technologies dépasse très probablement leur réelle capacité.

Billet inspiré de Social media scraping app Predictim banned by Facebook and Twitter, sur Sophos nakedsecurity.

Qu’en pensez-vous ? Laissez un commentaire.